티스토리 뷰

목적 : 이것도 AAnet Introduction 에서 existing CIL methods로 소개했다. 빨리 읽고 12시이후부터는 코딩해봐야한다.

Mnemonics Training: Multi-Class Incremental Learning without Forgetting

Abstract

- Multi-Class Incremental Learning(MCIL) 목표 :이전 개념에 대해 trained model을 incrementally 갱신하여 새로운 개념을 학습시키는 것

- inherent trade-off : Catastrophic forgetting vs learning new concepts

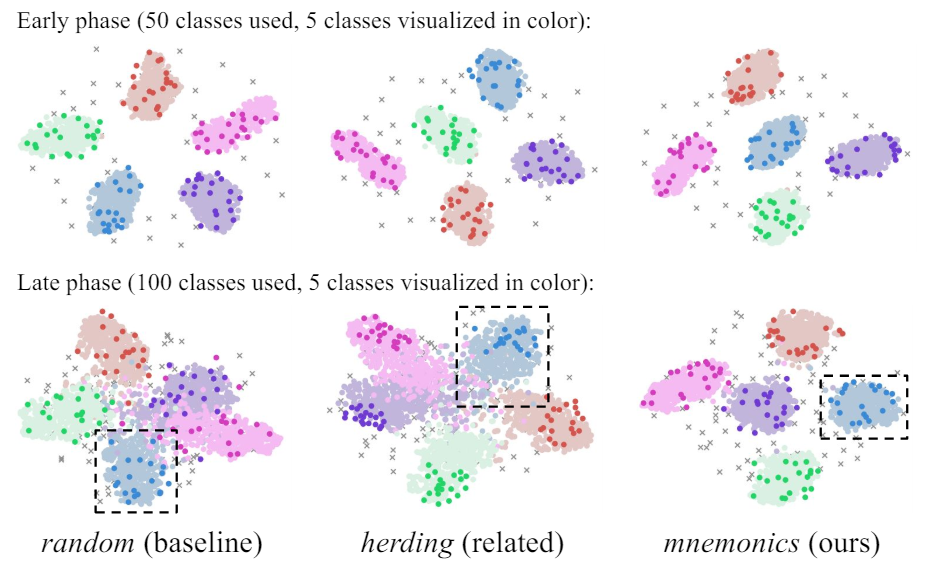

- representativeness of these examples에 크게 좌우된다. 본 논문에서는 mnemonics라는 novel and automactic framework를 제시하는데 examplars를 parametize하고 그것을 end-to-end 방식으로 최적화 할 수 있도록 한다.

- bi-level optimization을 통해 프레임워크를 훈련하고 세가지 실험(CIFAR100,ImageNet-Subset, ImageNet)에서 실험하니 mnemonics exemplars를 쓰는 것이 최첨단 기법보다 큰 폭으로 성능을 향상시켰다.

- 신기하게도 mnemonics exemplars는 boundaries beween classes 근처에 자주 위치한다. (신기하네)

- Random : exemplars들이 early phase에 무작위적으로 샘플링 됨.

- Herding : exemplars들이 early phase에 mean sample의 최근접 이웃들임.

'AI' 카테고리의 다른 글

| Gaussian Mixture Model 의 Clustering (0) | 2024.06.24 |

|---|---|

| abs summray for searching prototype (0) | 2024.06.15 |

| [LUCIR] CVPR'2019 (1) | 2024.06.01 |

| Herding Dynamical Weights to Learn (0) | 2024.06.01 |

| Adaptive Aggregation Networks for Class-Incremental Learning (0) | 2024.05.28 |

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- /var/log/fontconfig.log

- ctfloader

- torchmodel

- Arbitrary image stylization

- Deformable Part Model

- neural network applications

- batch란

- TransferLearning

- 1-stage detection

- /var/log/faillog

- DetectoRS

- Group Acitivty Recognition

- tf2to1

- Deformable Convolutional Networks

- 딥페이크탐지

- /var/log/tallylog

- tensorflow convert

- 도메인 어댑테이션

- max-margin_loss

- textual guidance

- Chatgpt4

- alternatives.log

- StyleCLIP

- 첫논문

- 샴네트워크

- /var/log/alternatives.log

- Source-free unsupervised domain adaptation

- yolov3 #tensorflow_convert

- tf version porting

- 전이학습

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

글 보관함